I de senere år har mobiltelefonernes verden oplevet store ændringer. Vi kan se grundlæggende forskelle i stort set alle aspekter, uanset om vi fokuserer på størrelse eller design, ydeevne eller andre smarte funktioner. Kameraernes kvalitet spiller i øjeblikket en relativt vigtig rolle. I øjeblikket kan vi sige, at dette er et af de vigtigste aspekter af smartphones, hvor flagskibene konstant konkurrerer. Når vi derudover sammenligner eksempelvis Android-telefoner med Apples iPhone, finder vi en række interessante forskelle.

Det kunne være interesserer dig

Hvis du er interesseret i mobilteknologiens verden, så ved du helt sikkert, at en af de største forskelle kan findes i tilfælde af sensoropløsning. Mens Androids ofte tilbyder et objektiv med mere end 50 Mpx, har iPhone kun satset på 12 Mpx i årevis, og kan stadig tilbyde billeder i bedre kvalitet. Dog er der ikke meget opmærksomhed på billedfokussystemer, hvor vi støder på en ret interessant forskel. Konkurrerende telefoner med Android-operativsystemet er ofte (delvist) afhængige af den såkaldte laser autofokus, mens smartphones med det bidte æble-logo ikke har denne teknologi. Hvordan fungerer det egentlig, hvorfor bruges det, og hvilke teknologier er Apple afhængige af?

Laserfokus vs iPhone

Den nævnte laserfokuseringsteknologi fungerer ganske enkelt, og dens brug giver rigtig god mening. I dette tilfælde er der skjult en diode i fotomodulet, som udsender stråling, når der trykkes på aftrækkeren. I dette tilfælde udsendes en stråle, som preller af det fotograferede motiv/objekt og returnerer, hvilken tid kan bruges til hurtigt at beregne afstanden gennem softwarealgoritmer. Desværre har den også sin mørke side. Når du tager billeder på større afstande, er laserfokuseringen ikke længere så præcis, eller når du tager billeder af gennemsigtige genstande og ugunstige forhindringer, der ikke pålideligt kan reflektere strålen. Af denne grund er de fleste telefoner stadig afhængige af den aldersbeviste algoritme til at registrere scenekontrast. En sensor med sådan kan finde det perfekte billede. Kombinationen fungerer rigtig godt og sikrer hurtig og præcis billedfokusering. For eksempel har den populære Google Pixel 6 dette system (LDAF).

Til gengæld har vi iPhone, som fungerer lidt anderledes. Men i kernen er det ret ens. Når der trykkes på aftrækkeren, spiller ISP- eller Image Signal Processor-komponenten, som er blevet væsentligt forbedret i de senere år, en nøglerolle. Denne chip kan bruge kontrastmetoden og sofistikerede algoritmer til øjeblikkeligt at evaluere det bedste fokus og tage et foto i høj kvalitet. Ud fra de opnåede data er det selvfølgelig nødvendigt at flytte linsen mekanisk til den ønskede position, men alle kameraer i mobiltelefoner fungerer på samme måde. Selvom de styres af en "motor", er deres bevægelse ikke roterende, men lineær.

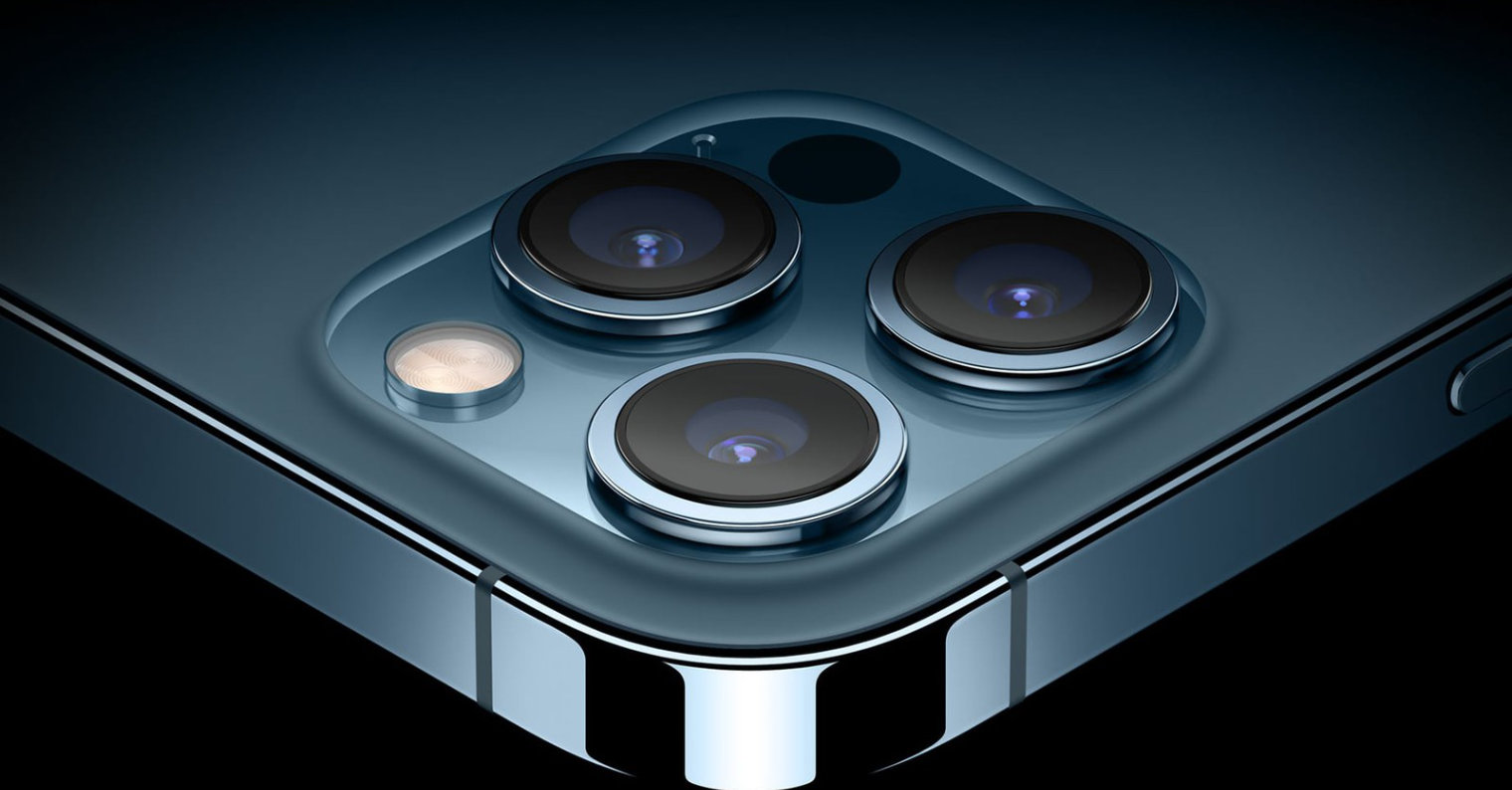

Et skridt foran er iPhone 12 Pro (Max) og iPhone 13 Pro (Max) modellerne. Som du måske har gættet, er disse modeller udstyret med en såkaldt LiDAR-scanner, som øjeblikkeligt kan bestemme afstanden fra det fotograferede motiv og bruge denne viden til sin fordel. Faktisk er denne teknologi tæt på det nævnte laserfokus. LiDAR kan bruge laserstråler til at skabe en 3D-model af sine omgivelser, hvorfor det primært bruges til scanning af rum, i selvkørende køretøjer og til at tage billeder, primært portrætter.

Det kunne være interesserer dig

Adam Kos

Adam Kos

Flyver verden rundt med Apple

Flyver verden rundt med Apple